本篇文章5551字,读完约14分钟

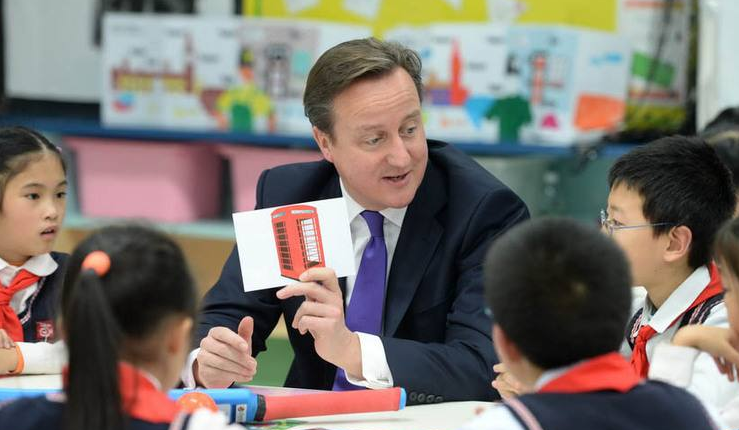

编者按:在阿尔法戈和李世石的第四场比赛中,李世石终于扳回一局。这场人机战争意味着什么?人类打开潘多拉的盒子了吗?阿尔法戈的胜利是否意味着人工智能的黑色方形纪念碑已经出现?本文将从alphago的原理出发逐步讨论这个问题。本文的作者,张,36 kr。,被授权转载自微信公众账号talkingdata(id:talkingdata)。

阿尔法戈已经和李世石打了四场比赛。在前三场比赛中,世界惊叹于阿尔法戈对李世石的全面粉碎,许多人呼吁人类药丸。围棋被认为是人类智慧的圣杯,在冰冷的机器(或疯狂的小狗)面前,它已经变成了一个唾手可得的普通杯子,而人类的顶级玩家似乎没有反击的力量。在3月12日的第四场比赛中,李世石终于扳回一局,下了一些令人惊叹的象棋。尤其是第78只手,Go,被许多人称赞为“上帝的一只手”、“载入史册的一只手”和“扼住命运咽喉的一只手”。因为这个游戏,Go Bar的主流舆论被震惊了,叹息了,难过了,甚至想到李石士拿谷歌的黑钱大吃一惊,甚至想到李石士找到了一个用棍子打狗的方法。人类药丸党认为这比AlphaGo 5:0的胜利更可怕,因为这只狗甚至知道如何玩假象棋来麻痹人类,这真的很可怕。

无论如何,阿尔法戈已经以3胜赢得了人类围棋大师赛的冠军,而李世石目前只是在为人类尊严而战。一年前,围棋通常被认为是10年内人工智能无法攻克的一道防线,但它瞬间成为了马其诺的一道防线。那么这场人机战争到底意味着什么呢?人类打开潘多拉的盒子了吗?阿尔法戈的胜利是否意味着人工智能的黑色广场纪念碑(图1,请参考电影2001:泰空漫游)已经出现?本文将从alphago的原理出发,逐步讨论这个问题。

图1

首先,阿尔法戈的原则

网上已经有很多文章介绍了alphago的原理,但是我认为想要深入了解它的原理的学生应该阅读自然中的原始论文“掌握深度神经网络和树搜索的围棋游戏”。虽然这篇文章有20页,但正文部分加上介绍一些细节的方法部分只有8页,其中包含了很多数字。就我个人而言,我认为最好介绍一下阿尔法戈的原理。为了便于下面的讨论,这里简要总结一下原理。

理论上,完全信息博弈,如围棋,可以通过对所有可能的博弈过程进行激烈的搜索来确定最优的行走方式。对于这类问题,其难度完全取决于搜索的广度和深度。1997年,深蓝解决了国际象棋,每一步的搜索宽度和深度分别约为35步和80步。围棋每一步的搜索宽度和深度分别约为250步和150步,搜索计算量远远超过象棋。减少搜索量有两个基本原则:1 .通过评估情况来减小搜索深度,即,当搜索达到一定深度时,用近似的情况判断函数(值函数)来代替更深的搜索;2.通过策略函数选择宽度搜索的步骤,通过剔除可能性较小的步骤来减小搜索宽度。两个简单的原则,但困难在于减少搜索量和获得最优解之间的根本矛盾。如何在尽可能减少搜索量和尽可能接近最优解之间取得平衡是最大的挑战。

暴力搜索和剪枝的传统方法在《围棋》中长期无法取得重大突破。直到2006年,蒙特卡罗树搜索在Go中得到了应用,在人工智能Go的能力上取得了重大突破,达到了前所未有的5-6段的业余水平。Mcts将博弈过程中的搜索视为一个多方博弈的强盗问题,并采用uct策略来平衡不同搜索分支中的探索和探索问题。MCT和强力搜索的区别在于它没有严格的深度优先或宽度优先。从搜索开始,它使用随机策略来选择搜索分支,这对于每一层都是正确的。随机搜索完成一次后,它将返回根节点开始下一轮搜索。纯随机搜索的效率非常低。就像解决多臂吃角子老虎机的问题一样,mcts记录每次搜索获得的收益,从而更新搜索路径上节点的获胜率。在下一轮搜索中,获胜率较高的分支可以获得较高的搜索概率。当然,为了平衡陷入局部最优的问题,概率选择函数还将考虑分支被搜索的次数,并且次数越少,被选择的概率越高。面对如此庞大的搜索空的围棋,这一基本策略仍然不可行。每个搜索过程中的搜索深度必须是有限的。原始MCT采用的策略是,当搜索节点的搜索次数小于某个阈值(在alphago中似乎是40)时,终止向下搜索。同时,利用模拟策略,从这个节点开始,通过一轮或几轮随机博弈来确定最终的利润。当搜索次数大于阈值时,搜索节点将向下扩展。维基百科上mcts条目的示例图(图2)显示了mcts的四个步骤:

图2

1.选择:根据子节点的成功率随机选择搜索路径。

2.扩展:当叶节点的搜索次数大于阈值时,新的叶节点向下扩展(如果没有先验,则随机选择)。

3.模拟:从叶子节点开始,随机下一轮或几轮棋,以获得最终利润。

4.返回:将搜索结果返回到搜索路径的每个节点,以更新获胜率。

图3

alphago的基本原理也是基于MCT的,但它一点也不深奥。然而,alphago已经在MCT上完成了两项主要的优化工作,这使得go人工智能从业余水平跃升到专业顶级水平。这两个优化任务是策略网络和价值网络,它们都是深层神经网络,本质上是两个函数。这两个网络分别解决了什么问题?在原MCT的选择步骤中,初始搜索只能随机选择孩子,其收敛效率明显很低。策略网络以当前情况为输入,输出每次合法行走的概率,作为选择步骤的先验概率,加速搜索过程的收敛。在模拟步骤中,价值网络根据当前情况直接给出收入的估价。应该注意的是,在alphago中,价值网络并不取代随机象棋的方法,而是与随机象棋并行运行(随机象棋在cpu上运行,价值网络在gpu上运行)。然后对两者的结果进行加权(系数为0.5)。当然,alphago的随机下棋也应该做大量的优化工作,这可能会借鉴一些以前的go人工智能工作。图3取自alphago论文,清楚地显示了战略网络和价值网络是如何将围棋人工智能从业余水平提升到专业水平的。因此,alphago的本质在于战略网络和价值网络。

策略网络可以抽象为,其中S是当前情况,A是行走方法,这实际上是当前情况下每种合法行走方法的条件概率函数。为了得到这个函数,alphago采用监督学习的方法,从kgs go服务器获得的3000万个场景中训练13层深层神经网络。该网络可以将步行预测的准确率提高到57%。如果这个问题被认为是一个多分类问题,当类别的平均数量大约为250时,57%的准确率是惊人的。在这个训练过程中,我们的目标是更多地关注行走对最终结果的影响,而不仅仅是人类行走的预测精度。这种深度学习网络的预测时间也相当耗时(需要3毫秒)。因此,alphago以更简单的方式训练了一个快速策略函数作为备份,其预测精度仅为24.2%,但预测时间仅为2微秒,比原来低1000个数量级。应该注意的是,alphago使用的实际策略网络是从人类象棋中学习到的,但是它没有使用通过自我游戏获得的策略网络来加强学习。这是因为在实战中,监督学习网络优于强化学习网络。

价值网络是一种责任函数,可以抽象为当前形势下的收入预期函数。价值网络有14个隐藏层,它的训练是通过情境和自我游戏过程中的最终结果来训练这一功能。

强化学习或自学的过程是alphago最吸引人的部分,也是药丸派对最令人担忧的部分。这一过程甚至被解释为一种繁殖方法,无数的阿尔法战士为自己而战,最后留下一个无比宽容的人。然而,读完这篇论文后,我们发现精读的效果并不是很大。首先,强化学习是基于用于学习人类象棋分数的监督学习网络,而不是从0开始。其次,强化学习网络不是用在实际游戏中,而是用在训练价值网络中。此外,在训练值网络中,不仅使用最强壮的狗,而且随机使用不同的狗。就个人而言,alphago中的强化学习主要用于创建不同风格的狗,然后通过这些不同风格的狗来训练价值网络,以避免价值网络的过度拟合。这可能是因为人类象棋分数的数量不足以训练足够的高级策略网络来支持价值网络的训练。

第二,阿尔法戈从人类经验中学到了什么?

就个人而言,阿尔法戈拥有一定程度的超级学习能力,可以轻松学习人类历史上玩过的所有国际象棋的分数(只要答谢国际象棋的分数可以数字化),并从这些人类经验中学习获胜的秘诀。但显然,从人类的角度来看,阿尔法戈玩围棋的逻辑绝对不美。Mcts框架与人类棋手的布局没有任何共同之处,只有冷暴力计算和概率权衡。战略网络已经学习了很多人类的战略经验,能够很好的判断该走哪一步,但是它不是基于Go的理解和逻辑推理。如果你问为什么选择这一步,战略网络给出的答案是,90%的人会在历史上迈出这一步。至于战略网络,它研究的是对当前形势的输赢优势的判断,但它不能给出一个合乎逻辑的答案,而只能回答根据历史经验,这种形势获胜的概率是60%。有人说这种能力接近人类直觉,但我认为人类直觉的机制应该复杂得多。我们的直觉不能给出判断的概率,或者人类思维的核心不是概率。阿尔法戈从大量人类经验中学到了许多相关定律(概率函数),但它没有学到任何因果定律。这应该是阿尔法戈和人类玩家之间最本质的区别。

3.阿尔法戈超越了人类智慧吗?

要回答这个问题,我们必须首先定义超越。如果我们能击败顶尖的人类玩家,那么阿尔法戈在围棋中的智能确实超越了人类。但是假设,人类不再玩围棋了,如果没有更新的人类棋谱,阿尔法狼的围棋智能能提高吗?从前面的分析来看,阿尔法戈的自我学习过程并不那么有效,对此我表示怀疑。也许人类沉淀的经验决定了阿尔法戈能力的上限,这个上限可能会高于人类的顶级大师。但是当人类不能继续发展Go时,阿尔法戈的能力就会停止。

从理论上讲,围棋中可能变化的数字是170位,这对人和计算机来说都是取之不尽的。无论是人类逻辑推理还是人工智能搜索策略,都不可避免地会陷入局部最优。目前,阿尔法戈的机制决定了它必须和人类一起掉进坑里(一些当地的optima)。如果人类不能挖掘新的矿坑(新的地方特色,或者新的Go风格和流派),阿尔法戈就不可能跳出旧的矿坑。从这个意义上说,不应该意识到阿尔法狼在围棋上超越了人类的智慧。

4.阿尔法戈会故意输给李世石吗?

12日,有人认为阿尔法戈故意输给李世石,要么是为了保存实力,要么是为了进入排行榜。但是从谷歌的开放原则来看,它显然没有做出这样决定的机制。阿尔法戈的机制是追求当局的胜利,根本不考虑局与局之间的关系,也没有人工智能大崛起的战略目标。阿尔法戈的故意损失只是一个玩笑。如果你真的想故意说,那只能由内心深处的人来做。

5.人类能打败阿尔法戈吗?

李世石赢了一场比赛。走吧。许多人认为人类已经找到了一根大狗棒来约束阿尔法戈。不要把狗当成人,不要用人的思维来对待狗,我们需要大胆地跳出过去的经验,寻找上帝的一只手。结合前面的分析,我认为这个想法是正确的。从本质上来说,阿尔法围棋是跟随人类围棋的发展。如果人类不能跳出自己的模子,他们只会被阿尔法戈碾碎,阿尔法戈在这个模子里什么也做不了。人类棋手可以通过他们自己的逻辑推理找到摆脱当前局部最优的方法。但这不是一件容易的事情,跳出经验主义思维更有可能陷入更大的逆向思维,这对于人们来说要求太高,只有顶级玩家才能做到。此外,阿尔法戈可以不间断地学习新的经验。其中一个神可能会打败阿尔法戈一次,但下次就没有机会了。阿尔法戈就像是掌握了国际象棋中的吸星法,人类要挑战他只会变得越来越困难。

6.阿尔法狼能做什么,不能做什么?

Deepmind的目标绝对不仅仅是围棋,围棋只是展示其人工智能奇迹的一个仪式。根据公开报道,下一步可能是星际争霸,然后是医疗保健、智能手机助手,甚至是政府、商业和战争决策。

在接受《边缘》采访时,德米斯·哈萨比斯透露,deepmind将专注于个人移动助理。Hassabis认为,目前的个人移动助理都是预编程的,太脆弱,无法适应各种情况,deepmind希望通过人工智能技术,特别是无监督的自我学习,拥有一个真正智能和真正智能的移动助理。这是因为智能手机的输入有太多的变化,需要大量的训练样本来学习有用的东西。这是阿尔法戈目前所依赖的方法。因此,哈萨比斯想挑战机器自学习成为主要的学习方法,他充满信心。但我认为这个问题可能不容易解决,因为自主学习在alphago中的作用相对有限。如果在相对简单的围棋环境中,自学的作用相对有限,那么在更复杂的环境中自学的挑战将会更大。然而,从talkingdata的角度来看,通过将我们的海量移动数据与监督学习技术相结合,可能更容易实现hassabis的愿景。

就我个人而言,我希望alphago能创造更大的奇迹,但我也认为它的应用有一些局限性。因为不是所有的实际问题都能找到这么多的训练数据。特别是在政府、商业和战争决策中,在耗尽人类历史之后,我们找不到许多精确的训练集,问题本身的复杂性超出了围棋的完全信息博弈。在这种情况下,恐怕很难学习到足够准确的战略网络和价值网络。这使得阿尔法戈的方法面临这些问题,这些问题可能根本无法解决。

7.阿尔法戈是什么意思?

虽然阿尔法戈在被人类视为智能圣杯的围棋上取得了巨大成就,但其基本机制并不具有颠覆性。要想用强大的人工智能实现星海,目前的计算机理论和技术只能被视为一枚工作火箭。然而,不能低估以阿尔法戈为代表的人工智能的突破性发展。毕竟,工作介质火箭把人类带入了“Tai/きだよ 0”时代。目前,人工智能已经能够更好地学习全人类在某些领域的经验。也许人工智能几乎不能创造任何东西,但至少它能把人类已经达到的高度推得更高,把人类从更多的重复性劳动中解放出来,为我们创造更好的生活和更好的环境。阿尔法戈是人类进步史上的重要一步,但它可能不是人工智能崛起的黑方纪念碑。

这篇文章由读者提交,并不代表36英寸的立场。如果转载,请注明出处

“读完这篇文章还不够吗?如果你也开始创业,希望你的项目被报道,请点击这里告诉我们!”

标题:AlphaGo:黑色方碑?

地址:http://www.j4f2.com/ydbxw/9270.html